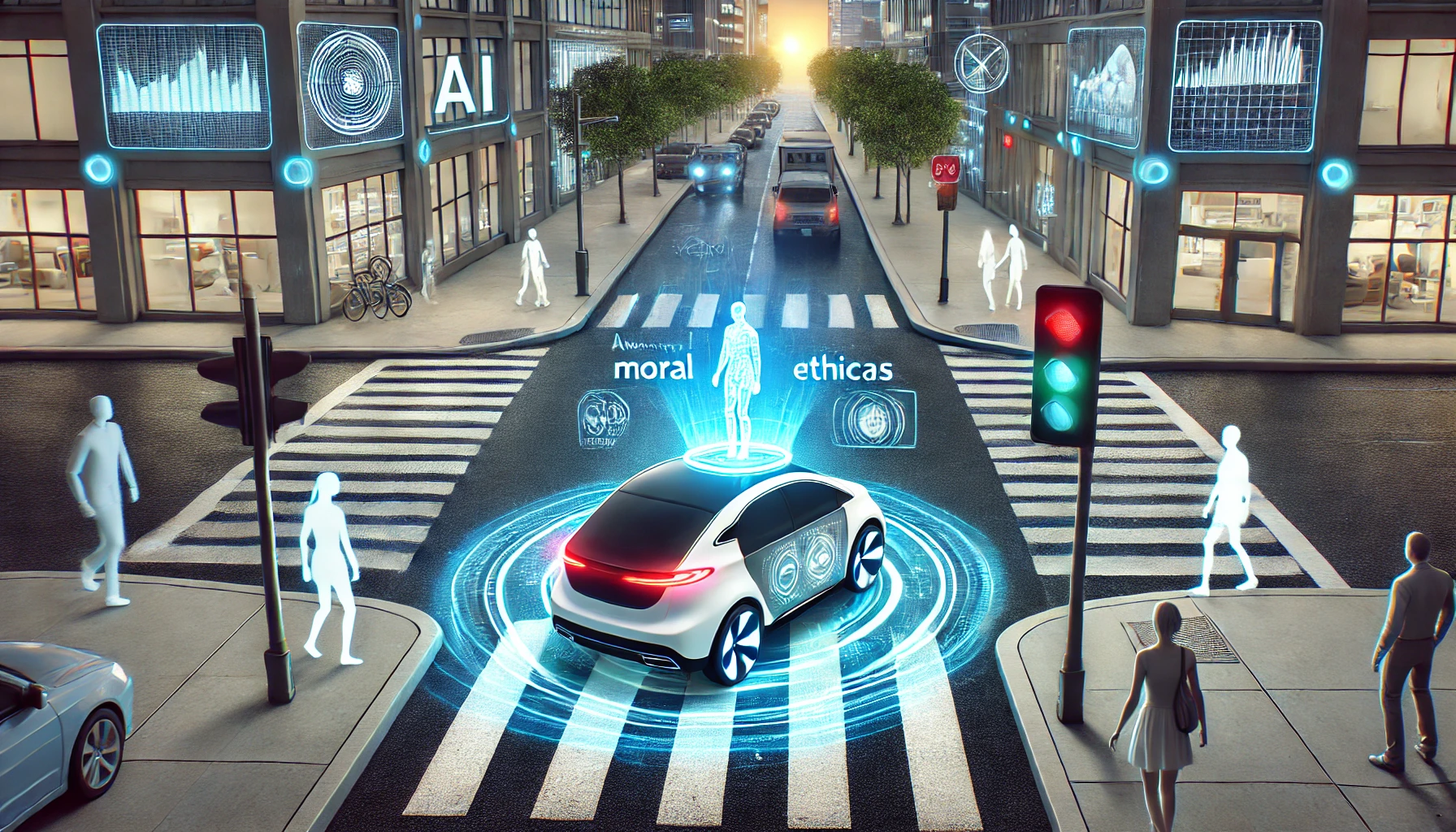

¿Puede una máquina tomar decisiones morales? Este dilema fue puesto a prueba por el experimento de la «Moral Machine», un proyecto desarrollado por el MIT (Instituto de Tecnología de Massachusetts) para estudiar cómo las personas perciben las decisiones éticas de las máquinas. En este artículo, exploraremos en qué consistió este experimento, sus resultados y cómo afecta al desarrollo de la IA en la actualidad.

¿Qué es la «Moral Machine»?

La «Moral Machine» es una plataforma interactiva lanzada en 2016 por el MIT para recopilar datos sobre las decisiones éticas que toman los humanos en situaciones de vida o muerte. El experimento presentaba escenarios hipotéticos en los que un vehículo autónomo debía decidir entre diferentes resultados potenciales en un accidente inevitable.

Los participantes debían elegir entre salvar a diferentes tipos de personas (niños, ancianos, peatones, pasajeros del vehículo, etc.) o incluso animales. Este experimento simulaba dilemas éticos complejos, similares al clásico «problema del tranvía» en filosofía.

Resultados del Experimento

Más de 40 millones de respuestas fueron recolectadas de personas en 233 países y territorios. Los resultados mostraron patrones interesantes sobre cómo varían las decisiones morales según la cultura y los valores sociales:

- Prioridad a salvar vidas humanas: La mayoría de los participantes priorizó salvar a los humanos sobre los animales.

- Preferencia por jóvenes sobre ancianos: Los niños tendieron a ser preferidos sobre los adultos mayores.

- Respeto por la ley: Personas que cruzaban legalmente la calle fueron favorecidas frente a las que cruzaban de manera ilegal.

- Factores culturales: En países más individualistas como EE. UU., se priorizó salvar a los jóvenes, mientras que en sociedades más colectivistas como Japón, hubo mayor equidad en las elecciones.

Implicaciones Éticas para la IA

La «Moral Machine» destacó la complejidad de programar decisiones éticas en algoritmos de IA. Este experimento abrió un debate sobre quién debería decidir cómo programar estas decisiones en sistemas autónomos, como los vehículos sin conductor.

1. Desafíos en Programación Ética: La ética es subjetiva y varía según la cultura y los valores individuales. ¿Debería una IA seguir principios universales o adaptarse a las normas culturales del lugar donde opera?

2. Responsabilidad Legal y Moral: En un accidente provocado por un vehículo autónomo, ¿quién es responsable? ¿El fabricante, el programador o el usuario? Este tipo de dilemas legales aún no tienen respuestas claras.

3. Transparencia en la IA: Los algoritmos deben ser transparentes para que los usuarios entiendan cómo toman decisiones. La falta de claridad puede generar desconfianza hacia estas tecnologías.

Aplicaciones Actuales de la «Moral Machine»

El experimento ha influido en el desarrollo de sistemas autónomos y la creación de regulaciones. Algunas aplicaciones clave incluyen:

- Vehículos autónomos: Los datos recopilados se utilizan para entrenar sistemas de IA que puedan tomar decisiones en fracciones de segundo en caso de accidentes.

- Robots asistenciales: Programación de robots que interactúan con humanos en hospitales o residencias de ancianos, garantizando decisiones éticas.

- IA en la justicia: Uso de algoritmos para evaluar casos legales y determinar sentencias, aunque este uso sigue siendo polémico.

Conclusión

El experimento de la «Moral Machine» ha dejado claro que las decisiones éticas no son fáciles de programar en una máquina. Sin embargo, también ha abierto puertas para entender mejor cómo podemos entrenar a la IA para actuar de manera responsable y justa. A medida que la tecnología avanza, será crucial seguir debatiendo sobre el papel de la moral en la IA y garantizar que estas herramientas se utilicen para mejorar nuestras vidas, sin comprometer nuestros valores fundamentales.

¿Estarías dispuesto a confiar en una máquina para tomar decisiones morales por ti? Esa es una pregunta que el futuro de la IA nos obligará a responder.